港科& DeepWisdom揭示AI搜索交互盲点

- 2025-11-03 03:58:49

港科& DeepWisdom揭示AI搜索交互盲点

尽管语言智能体在信息检索和网页搜索中表现强劲,但现实用户的查询往往模糊不清,需多轮澄清。现有搜索代理普遍假设“用户问题完整”,缺乏交互机制。香港科技大学(广州)与DeepWisdom等团队联合推出 InteractComp 基准,用于评估AI搜索代理能否识别并主动化解查询歧义,为智能体“学会提问”提供了首个系统性验证框架。

核心亮点:

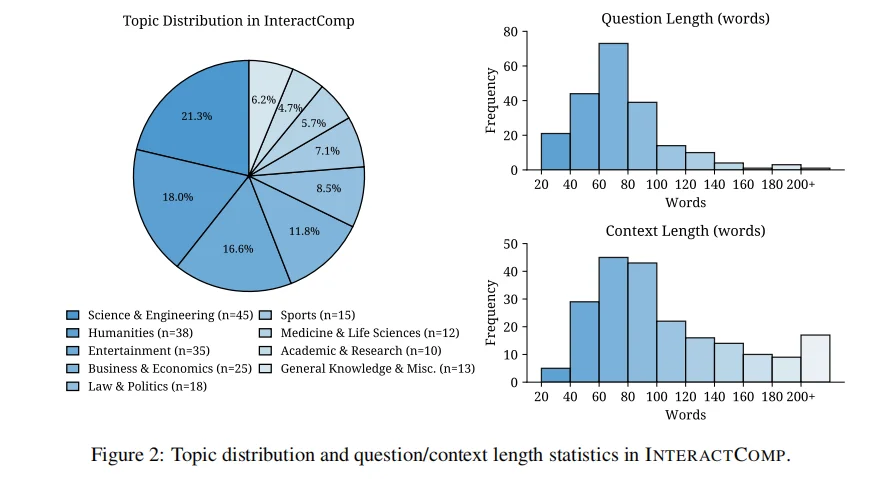

首创交互式搜索基准:以“易验证、靠互动消歧(Easy to verify, interact to disambiguate)”为设计原则,构建210个专家题目,覆盖9大领域(科技、人文、娱乐等),同时支持中英双语。

目标-干扰法生成歧义问题:每道题由相似实体对构成(如冷门目标 vs 流行干扰项),问题仅包含共有属性,正确答案需通过互动获取隐藏特征才能区分。

三阶段任务流程:智能体可选择搜索(search)、提问(interact)或作答(answer);用户模拟器仅基于上下文以“yes/no/不知道”应答,逼真模拟澄清过程。

系统性评测17大模型:包括GPT-5、Claude-Opus、Gemini 2.5、DeepSeek-R1、Qwen3等;结果显示最佳模型(GPT-5)准确率仅13.73%,而有完整上下文时可达71.5%。

揭示系统性过度自信问题:错误源非推理缺陷,而是模型缺乏不确定性感知与主动求证行为。强制提问可使准确率提升至40%。

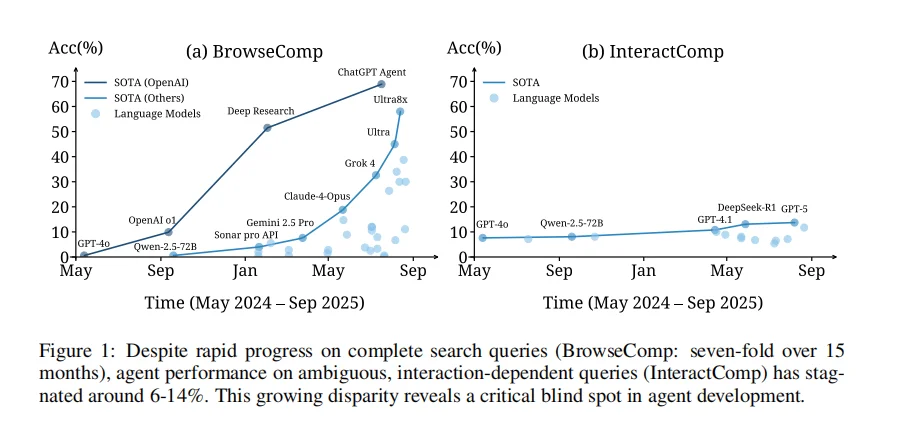

15个月纵向分析:搜索性能提升7倍(BrowseComp达70%),但交互能力停滞在6–14%,暴露智能体发展的“盲区”。

为RL训练提供清晰奖励信号:搜索任务结果天然可验证,适合作为强化学习与人机交互能力训练的新基准。

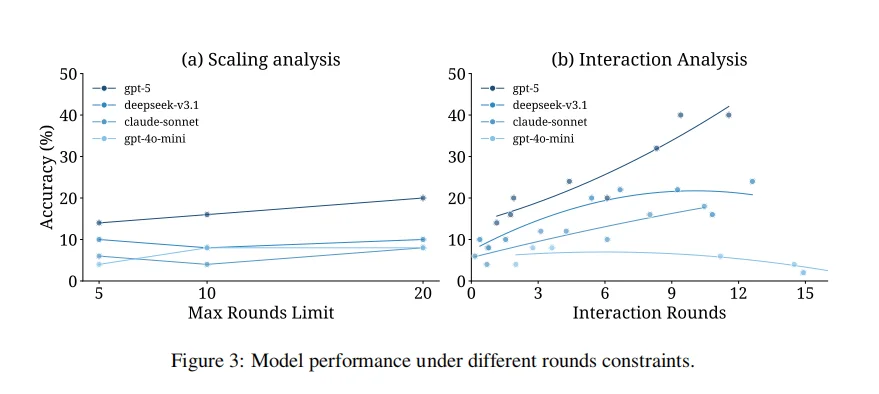

应用场景 / 用户反馈 / 实验结果: 适用于搜索代理、AI助手、对话式检索系统、RLHF/RLAIF训练框架研究者。 实验发现,单纯增加对话轮次(5→20轮)几乎无益,而“强制互动”显著改善表现。DeepSeek-R1与GPT-5在强制提问下均出现性能倍增,验证了交互潜力“被掩盖而非缺失”。

🔗 项目/论文

GitHub仓库路径

FoundationAgents/InteractComp

arXiv:2510.24668

#AI代理 #信息检索 #交互 #搜索增强 #模糊查询 #强化学习 #ai评测 #hkust #DeepWisdom #智能体

核心亮点:

首创交互式搜索基准:以“易验证、靠互动消歧(Easy to verify, interact to disambiguate)”为设计原则,构建210个专家题目,覆盖9大领域(科技、人文、娱乐等),同时支持中英双语。

目标-干扰法生成歧义问题:每道题由相似实体对构成(如冷门目标 vs 流行干扰项),问题仅包含共有属性,正确答案需通过互动获取隐藏特征才能区分。

三阶段任务流程:智能体可选择搜索(search)、提问(interact)或作答(answer);用户模拟器仅基于上下文以“yes/no/不知道”应答,逼真模拟澄清过程。

系统性评测17大模型:包括GPT-5、Claude-Opus、Gemini 2.5、DeepSeek-R1、Qwen3等;结果显示最佳模型(GPT-5)准确率仅13.73%,而有完整上下文时可达71.5%。

揭示系统性过度自信问题:错误源非推理缺陷,而是模型缺乏不确定性感知与主动求证行为。强制提问可使准确率提升至40%。

15个月纵向分析:搜索性能提升7倍(BrowseComp达70%),但交互能力停滞在6–14%,暴露智能体发展的“盲区”。

为RL训练提供清晰奖励信号:搜索任务结果天然可验证,适合作为强化学习与人机交互能力训练的新基准。

应用场景 / 用户反馈 / 实验结果: 适用于搜索代理、AI助手、对话式检索系统、RLHF/RLAIF训练框架研究者。 实验发现,单纯增加对话轮次(5→20轮)几乎无益,而“强制互动”显著改善表现。DeepSeek-R1与GPT-5在强制提问下均出现性能倍增,验证了交互潜力“被掩盖而非缺失”。

🔗 项目/论文

GitHub仓库路径

FoundationAgents/InteractComp

arXiv:2510.24668

#AI代理 #信息检索 #交互 #搜索增强 #模糊查询 #强化学习 #ai评测 #hkust #DeepWisdom #智能体

本文来自网友投稿或网络内容,如有侵犯您的权益请联系我们删除,联系邮箱:wyl860211@qq.com 。